こんにちは。ITコンサルタントの島田です。

世の中でDX(デジタルトランスフォーメーション)がバズワードとなり久しいですが、組織の上層部が急にDX推進を掲げ「これまで蓄積されていたデータを分析せよ」「AIを使って何かせよ」といった半ば無茶な要求を出して現場が困っている、という話を何度か耳にしたことがあります。

このコラムでは「データ分析って何をすれば良いの?」「どう進めれば良いの?」という疑問に対して何らかのヒントをご提供できれば、という思いで、データ分析の標準的なプロセスや留意点を解説していきます。

手元のデータをどう活用すべきか検討している方はぜひご覧ください。

目次

データ分析とは?

IT化の進展とともに、企業活動においてさまざまなデータが蓄積されています。加えて「ビッグデータ」という言葉が人口に膾炙するようになったここ10年ほどで大量のデータを高速で処理できる技術も普及し、データから課題解決のタネや新しいビジネスのヒントを見出す試みが数多く生まれてきました。

このような取り組みが、ビジネス用語としての「データ分析」として注目を集めています。データの有効活用は、企業にとってもはや必須のミッションであると表現しても過言ではないでしょう。

しかし、溜め込んだままの状態でデータが価値を生むことはほとんどありません。データ分析の文脈では「Data-Mining」という言葉がしばしば登場しますが、「mining」の原型「mine」は「磨く」という意味であり、まさにデータは磨くことが必要という含意がここにあります。

そして、そのデータを磨く作業やその先の解釈、すなわち分析全般をお手伝いするのが「データサイエンティスト」と呼ばれる人々です。

データ分析の準備

「データ分析と料理は似ている」

と、私は感じています。

まず調理器具。包丁やまな板、鍋などが揃っていないと料理はできません。データ分析でも、AIやいろいろ便利なライブラリ等、道具を上手に使うことが重要です。

次に食材。道具だけ揃えても食材がなければ何も作れません。そして食材は、調理することでおいしくなります。例えばどんなに良い鯛でも、そのままではまず食べられません。鱗や骨、内臓を取り除き、食べやすい大きさに切ることで初めてお刺身としておいしくいただけるようになります。煮魚にしても焼き魚にしても、それなりのプロセスがありますよね。

データ分析も同じでプロセスが非常に重要です。いわゆる「生データ」のままで有効活用できるデータは稀であり、人にとって価値がある形に加工することで始めて、人が解釈して「おいしい」と感じる有効な結果を生み出すことができるのです。

データ分析標準プロセス「CRISP-DM」

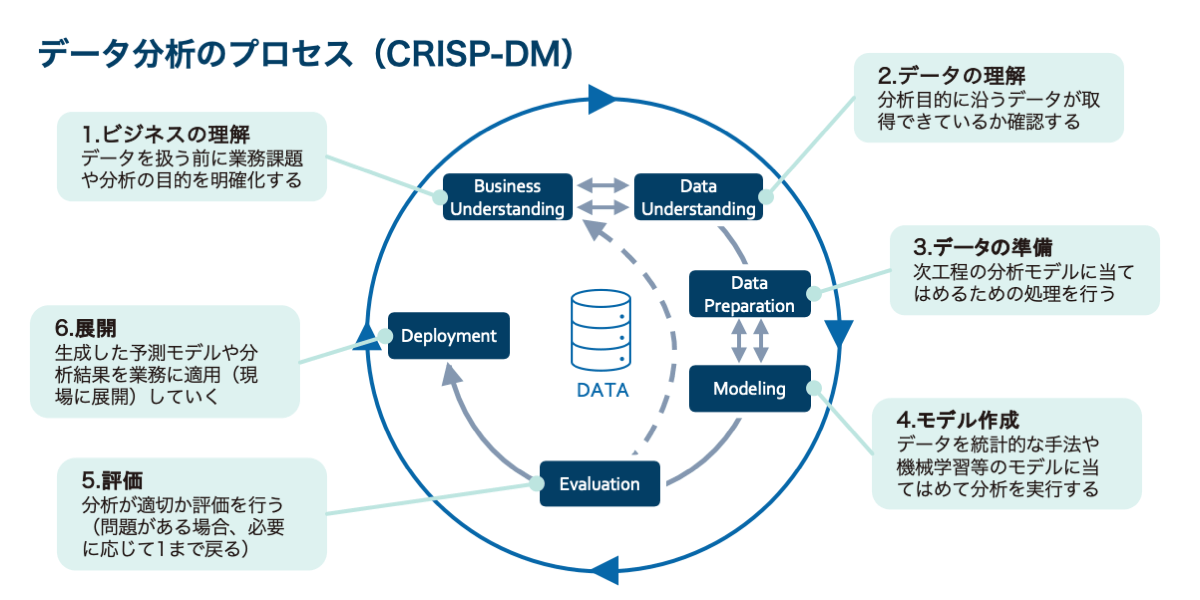

「CRISP-DM」とは、「CRoss-Industry Standard Proccess for Data Mining」の略語で、業種業界に捉われない、データ分析を行う際に採るべき標準的なプロセスを体系化したものです。

この体系を知っているだけでも、「データ分析ってデータを分析するだけではダメなのか!」というあまりにも当然、しかし極めて重要な点を心に止めておくことができます。実際に分析を行う人だけでなく、データ分析を依頼する立場の人にも知っておいていただくと良いと思います。

CRISP-DMは、6個のフェーズで構成されています。この6個は一方向に流れるのではなく、必要であれば前のフェーズに戻ったり、最初からやり直したりすることがあります。

1.Business Understanding(ビジネスの理解)

業務課題や分析の目的を明確化します。何らかデータ分析をする際には、このフェーズが非常に重要です。

「何を知りたいのか」

「何を解決したいのか」

「どんな仮説を検証したいのか」

等々、ビジネスの現状やプロジェクトに求められている役割から、分析で突き詰めるべき課題を明確にするのがデータ分析の最初のプロセスです。

先ほど「データ分析と料理は似ている」と書きましたが、目的を定めず「AI使って何かやって」という依頼をするのは、食べたい料理を伝えず「包丁使って何か作って」と依頼するくらい意味がないことです。「食べられそうなもの」があり「包丁を使えそうな人」がいるからといって、何か調理してもらえば自分の望んだ料理が出てくると考えるのには無理があるのと同じです。

このコラムを読んでくださっている方は、ぜひ部下や協力会社に「AI使って何かやって」というような無謀な依頼をしないようにお願いします。

また、上司からこうした指示を受けてしまっている方は、闇雲に作業に着手する前に、できる範囲で要求を明確化するようにお願いをしてみてください。

何を作っているのかわからずただ料理をはじめても、満足のいく食事は提供できないはずですから。

2.Data Understanding(データの理解)

目的を明確化したら、次に必要なのが分析対象となるデータの理解です。

「分布は偏っていないか」

「必要な項目は揃っているか」

「欠損値はどの項目に何個くらいあるか」

など、データの特徴を確認していきます。

3.Data Preparation (データの準備)

続いて、実際にデータを加工する作業を実施します。データの準備には主に「データクレンジング」と「特徴量の生成」があります。

データクレンジングは、「データを『人間にとって』見やすくする作業」のことを指します。代表的なものとして、欠損しているデータの削除や補正が挙げられます。

特徴量生成は、「データを『機械にとって』見やすくする作業」です。

データ分析というと、どうしても次のステップ「モデリング」が着目されがちですが、実際に作業の大部分を占めるのは、この「データの準備」のステップです。

4.Modeling(モデリング)

データの準備が整ったところで、統計的な分析手法や機械学習、深層学習等を用いたモデリングを実施します。

モデリングの手法には複数の種類があり、基礎的なものだと回帰分析による回帰式の算出から、最近のものだとAIを使った予測モデルや画像判定モデル等の生成等が挙げられます。

また、手法の選択に先立ち、株価予測のように具体的な数値を予測する問題(回帰問題)にするのか、あるいは感染症や疾患の陽性判定のように陽性/陰性といった真偽を予測する問題(分類問題)にするのか等、問題の設定方法を検討・決定します。

5.Evaluation(評価)

生成した予測モデルの精度に問題がないか、過学習(特定の学習データの傾向だけを偏って学習すること)していないか、といった観点で評価を実施します。

評価で問題があった場合は、データの量や変数、学習の方法等をあらためて見直し、データの準備やモデリングを再度実施します。必要に応じて最初のステップ(ビジネスの理解)まで立ち戻り、課題設定を変更することもあります。

6.Deployment(展開)

CRISP-DMの最後のプロセスです。生成した予測モデルや、分析結果に基づく新たな手順を業務に適用していきます。

知見を現場と共有して業務的なアクションに反映してもらう、というライトなものから、予測モデルをアプリ化して業務フローを刷新するといった大掛かりなものまで、多様な展開方法がありますので、目的や予算に応じて最適なものを選択します。

一番大切なことは「問い」を立てること

こうして体系化されたプロセスを眺めるだけでも「データ分析と一言で表現すると単純そうに見えるけど、一筋縄ではいかないものだ」とご理解いただけるかと思います。

この「CRISP-DM」を意識して作業計画を立ててみるだけでも、必要なことや不足していることが見えてくるのではないでしょうか。

何より大切なのは、「何を知りたいのか」「何を解決したいのか」といった「問い」を立て、洗練させていくことにあると、私は考えています。

実は、頭の中に浮かんでいる課題や疑問がそのままプロジェクトが追究する問いになることは、そう多くはありません。むしろ、何を突き詰めたいかは、分析が進むに連れて変化していくのが普通です。

プロジェクトの進行中は常に「何を目的として分析を進めているのか」をメンバー全員が意識・共有し、必要に応じてその問いの見直しも全員で考えてみることが、データ分析プロジェクトにおいて最も重要なことではないかと思います。

データ分析を外部に委託するには?

「問いの共有」が最重要

上述した「問いの共有」は、特に分析の実務を外部に委託する際には一層意識すべき点です。この場合、どうしても委託者は「業務」、受託者は「データ」に軸足を置きがちで、気付いたら互いの問いの設定がチグハグなものになっていて期待した成果が出てこない、というケースもあります。

このような齟齬を予防すべく、常に問題意識の共有を図ることがプロジェクト成功のキーとなります。

提供データは深く考えなくて良い

「受託者に渡すデータの準備はどうすれば良いの? 手元に分析してみたいExcelファイルが大量にあるけれど、そのまま渡しても何もできないよね?」といった疑問をお持ちの方もいらっしゃるかもしれません。

先に書いた通り「生データ」のままで有効活用できるデータは稀なのですが、基本的に、依頼側で事前にファイルを整形・加工していただく必要はありません。個人情報や業務上の機密情報だけをチェックして取り除いていただければ、あとはExcelでもcsvでもテキストファイルでも、データの形式は何でもかまいません。

(「こんなエクセルデータを大量に持っているけど、分析に使えますか?」というご相談のある方はぜひNCDCにお問い合わせください)

委託先の選び方

誰に(どういう会社に)データ分析に委託すべきか迷った時は、特に「問いの共有」を重視すると良いと思います。相談の時点で、相手がこうした姿勢を持っているかどうかを注視してみてください。

データ分析の担当者に「依頼者のビジネスを理解し、問いを共有しよう」という姿勢がない場合、何かしらの分析は行えたとしても、あまりビジネス面で有意義な結果は得られないかもしれません。

便利なデータマイニングツールを活用しましょう!

データ分析というと、どうしてもプログラミングスキルが必須であると思われがちですが、最近ではプログラミングをしなくてもデータの加工や分析ができるツールが複数登場してきています。

ある程度知識があって、自分でデータ分析に取り組んでみたいという方は「データマイニングツール」を使うと便利です。

代表的なものとして、「KNIME」をご紹介します。日本語に対応していないので一見難しそうに見えますが、基本的な機能は無料で使用できます。実施したい処理をフロー形式に繋げていくことで、クレンジングや特徴量の生成が簡単にできますし、基本的な機械学習やニューラルネットワークのアルゴリズムも搭載しているので、モデリングや評価まで実行することができます。

また、KNIMEはテキストやCSVだけでなく、Excel形式のファイル入出力にも対応しており、ファイル形式の変換等の事前準備もおよそ必要ありません。

「こんな分析をしたい、そのためにはこんなクレンジングが必要」という目的・方針がある程度はっきりしている場合や、分析の流れをITに明るくないメンバーと共有したい場合には有効に活用できるかと思います。

DXのご相談はNCDCへ!

NCDCはデータ分析の知見のみならず、新規事業やDXに関する企画・実行支援やシステム構築のノウハウが豊富に揃っております。

データ分析に際しての問いの策定・洗練から分析実務、分析結果に基づいたビジネス戦略の策定、新たなシステムの設計構築まで、さまざまな分野のスペシャリストによるワンストップでのご支援が可能です。データ分析の支援を含め、DXや新規事業の立ち上げ、実行に関してのお困りごとは、ぜひNCDCへご相談ください。